Comprendre les concepts comme IA et la génération d’image sans expertise du domaine?

Il ne s’agit pas pour un artiste comme moi de maîtriser le sujet, mais plutôt d’acquérir un certaine culture générale et comprendre pourquoi chaque modèle peut réagir différemment au même script en entrée.

J’ai lu de nombreux livres sur la définition de l’intelligence artificielle et sur son histoire. Je ne compte pas d’en faire une synthèse, il y a de nombreux ouvrages pour ceux qui ont envie de comprendre, parfaitement rédigés par les spécialistes.

J’ai simplement posé la question au Chat GPT par curiosité pour voir si la réponse est correcte. Je la publie, car c’est un bon résumé et je ne ferais pas tellement mieux. C’est une petite introduction avant d’aborder le sujet de la génération d’image.

L’intelligence artificielle (IA) fait référence au développement de systèmes informatiques capables d’effectuer des tâches nécessitant généralement une intelligence humaine, tels que l’apprentissage, la résolution de problèmes, la prise de décision et le traitement du langage. Il existe plusieurs approches pour développer des systèmes d’IA, notamment l’apprentissage automatique, les systèmes basés sur des règles et le calcul évolutif.

L’apprentissage automatique est un type d’IA qui implique la formation d’un système informatique sur un grand ensemble de données, lui permettant d’apprendre et de prendre des décisions en fonction des modèles et des relations dans les données. Il existe plusieurs types d’apprentissage automatique, notamment l’apprentissage supervisé, l’apprentissage non supervisé et l’apprentissage par renforcement.

Dans l’apprentissage supervisé, le système est formé sur un ensemble de données qui comprend des données d’entrée et la sortie correcte correspondante, et le système apprend à faire des prédictions basées sur ces données.

Dans l’apprentissage non supervisé, le système ne reçoit aucune donnée étiquetée et doit apprendre à identifier les modèles et les relations dans les données par lui-même.

Dans l’apprentissage par renforcement, le système apprend par essais et erreurs, recevant des récompenses ou des punitions en fonction de ses actions et ajustant son comportement en conséquence.

Les systèmes d’IA peuvent également être développés à l’aide de systèmes basés sur des règles, dans lesquels un ensemble de règles ou de critères de prise de décision sont explicitement programmés dans le système. Ces systèmes sont généralement utilisés pour des tâches qui impliquent des règles bien définies, telles que jouer aux échecs ou diagnostiquer une condition médicale.

Enfin, le calcul évolutif est un type d’IA qui consiste à utiliser des algorithmes inspirés de l’évolution naturelle, tels que des algorithmes génétiques, pour résoudre des problèmes ou optimiser des solutions.

Dans l’ensemble, les systèmes d’IA peuvent être très complexes et impliquer une combinaison de différentes approches et technologies. En comprenant le fonctionnement de l’IA, ses capacités et ses limites, nous pouvons mieux comprendre son potentiel et son rôle dans nos vies.

Qu’est-ce que la génération d’images.

Avant d’expliquer les particularités des différents outils disponibles, définissons ce premier terme important.

On peut dire de manière simplifiée que l’algorithme analyse une entrée de données et génère des visuels à partir de ces informations. Ces instructions sont soit des images, soit des scripts en langage naturel, soit les deux (nous assistons à un début du mode multimodal depuis 2021 en particulier dans l’environnement IA de Google).

Tout d’abord, il faut bien préciser que nous ne parlons pas de la reconnaissance d’images, mais bien de la génération d’image.

Si nous revenons au passé récent, depuis les années 2000, les premiers « réseaux de neurones » ont su générer des visuels réalistes. En 2014, grâce à Goodfellow, on a pu introduire l’algorithme appelé les réseaux adverses génératifs GAN (Generative adversarial networks).

Le traitement d’image est devenu aussi plus performant grâce à l’arrivée de nouvelles cartes graphiques NVDIA (depuis 2005) destinées à accélérer les travaux de traitement d’images.

C’était la période de naissance des applications que je vais appeler d’image à image.

L’utilisateur devait fournir des séries de visuels à analyser en amont et la machine proposait à son tour une représentation calculée, on peut dire « statistique », selon le paramétrage du modèle. Le collectif d’artistes Obvious vont utiliser GAN pour créer le Portrait Edmond de Belamy vendu très cher en 2018 comme le ‘premier portrait réalisé par l’IA’.

C’est également ainsi que j’ai pu commencer à expérimenter les premiers algorithmes pour fabriquer des images générées à partir de mes dessins et photos en 2019 via le studio américain Playform.io, nous n’étions pas très nombreux à faire tourner les modèles et se satisfaire des résultats en 2019.

A peine trois années plus tard, la situation a considérablement évolué dès 2022, grâce aux prototypes acceptant les directives en langage naturel qu’on appelle aussi text-to-image.

Pourquoi? Parce que’on écrit l’instruction ‘en texte’ pour obtenir une ‘image’.

Cela change beaucoup de choses.

Ainsi, n’importe qui est capable de produire une image sans aucune compétence particulière. C’est à couper le souffle, effrayant et frustrant en même temps. Nous devrons apprendre à vivre avec ces applications à partir de maintenant.

Et les artistes, graphistes et photographes sont particulièrement concernés par cette évolution.

Comment un logiciel de texte-to-image peut-il comprendre notre demande ? D’où vient cette révolution soudaine ?

Cette nouvelle avancée est liée aux progrès de l’apprentissage du langage humain par la machine. Pour analyser notre demande, le modèle utilise un algorithme NLP (traitement du langage naturel) qui tentera d’interpréter au mieux notre formulation, appelée « prompt ».

NLP (traitement du langage naturel) qui est au cœur de cette capacité est une branche de l’IA et un domaine multidisciplinaire impliquant la linguistique, l’informatique et l’intelligence artificielle. NLP a été conçu à l’origine pour créer des applications en langage naturel telles que des assistants de traduction ou des chatbots. Tout le monde connaît le ChatGPT, c’est aussi une conséquence du progrès dans le domaine du NLP.

NLP imite la compréhension humaine des mots et des phrases, c’est-à-dire de l’idée ou du « concept ».

Les générateurs d’images text-to-image peuvent générer une image aussi grâce à cette compréhension des instructions en langage courant. Nous verrons plus loin comment on passe de l’instruction exprimée en texte à l’image.

Le langage est essentiel pour donner un sens à la vie quotidienne.

Arrêtons-nous toutefois un peu sur cette capacité à “comprendre (analyser) le langage humain”.

Le langage est essentiel pour donner un sens à la vie quotidienne : nous avons l’habitude de communiquer, de partager des pensées et d’exprimer des notions. Un artiste travaille également avec des représentations et des concepts qui sont souvent interprétés visuellement avec plus ou moins d’intention et de conscience. Les générateurs d’images peuvent ainsi construire une image grâce à cette compréhension. Sont-ils capables de créer comme un artiste ?

La capacité des algorithmes à créer des images est limitée par les données sur lesquelles ils sont formés. Lorsque j’utilisais les GAN avec de petites séries de données, le résultats n’était pas franchement impressionnant. Mais actuellement, les séries d’apprentissages sont devenus tellement énormes que cela change radicalement le résultat.

Les algorithmes d’IA sont capables d’analyser de grandes quantités d’informations et d’identifier des modèles et des relations au sein de ces données. Ils n’ont pas du tout le même type de pensée créative et de prise de décision que les humains. Les images générées par ces algorithmes peuvent être basées sur des modèles et des relations qu’ils ont appris de leurs données d’entraînement. C’est une vision computationnelle, statistiquement calculée du réel. Elle n’implique pas la compréhension au sens humain du texte ou de l’image.

Cela étant dit, les algorithmes d’IA s’améliorent et évoluent constamment, et il est possible qu’ils puissent éventuellement générer des images encore plus originales et créatives dans le futur.

J’ai vu la fulgurante amélioration en trois années et je ne me fais pas beaucoup d’illusion sur la progression des modèles dans un future proche.

Pour le moment, il est important toutefois de reconnaître leurs limites, d’aborder leur utilisation dans l’art avec un regard critique et les considérer surtout comme un nouvel outil de travail et d’inspiration. Mais, il ne faut pas nier que le bouleversement dans des métiers graphiques est bien en route.

Mais comment ces solutions s’y prennent-elles pour concevoir l’image à partir du texte ?

Les applications convertissent un script, un ensemble d’instructions ou un ensemble de données en suggestion sous forme de pixels, car elles ont déjà été formées, par exemple, avec des millions de paires image/légende. Sans entrer dans les explications technologiques, il existe plusieurs méthodes pour créer la proposition picturale, mais cela nécessite toujours une étape préalable d’apprentissage automatique.

Les solutions les plus populaires sont DALL-E, Midjourney et Stable diffusion.

Dans l’ensemble, ces modèles diffèrent en termes d’architectures spécifiques, de méthodes et de formats d’entrée et de sortie. On peut dire que nous connaissons de nombreux ingrédients mathématiques disponibles, mais nous ne savons pas toujours la recette et donc la composition exacte et les modalités d’assemblage. C’est parfois un peu le secret du chef cuisinier.

Pour rester simple, voici quelques exemples de ces ‘ingrédients’ possibles :

Réseaux antagonistes génératifs (GAN, Generative Adversarial Networks) : Il s’agit d’un type de modèle d’apprentissage automatique composé de deux réseaux neuronaux : un générateur et un discriminateur.

Le générateur est formé pour créer de nouvelles images similaires à un ensemble de données d’exemples d’images en entrée, tandis que le discriminateur est formé pour déterminer si une image est réelle ou générée. Les deux réseaux sont entraînés ensemble, le générateur essayant de créer des images qui peuvent tromper le discriminateur et le discriminateur essayant d’identifier correctement les images réelles et générées. D’où l’appellation ‘antagoniste’.

Auto encodeurs variationnels (VAE, Variational Autoencoders) : Il s’agit d’un type de modèle d’apprentissage automatique qui peut générer de nouvelles images en apprenant une représentation compacte d’un ensemble de données d’images -exemples, puis en échantillonnant à partir de cette représentation pour générer de nouvelles images.

Transfert de style d’image (Image Style Transfert): Cela implique d’utiliser l’apprentissage automatique pour modifier le style d’une image existante, tout en préservant le contenu. Par exemple, une image d’un paysage pourrait être transformée pour avoir le style d’une peinture célèbre. Ces fonctionnalités ont été depuis quelque temps disponibles par exemple dans le logiciel Photoshop. J’ai pu également utilisé ces fonction sur ma plateforme Playform.io dans une version expérimentale en croisant deux séries d’images. J’ai ainsi transféré les textures à partir des images de gingembre sur les images de portraits humains pour obtenir une texture du visage assez intéressante (voir plus bas).

L’algorithme de diffusion (Diffusion based-algorithme) est un algorithme d’apprentissage automatique qui utilise un processus de diffusion pour générer des images basées sur un ensemble de paramètres d’entrée. L’idée derrière cette approche est de modifier itérativement une image initiale d’une manière guidée par les paramètres d’entrée, dans le but de produire une image visuellement similaire à l’image d’entrée. L’algorithme de ce type vise à résoudre certains des problèmes de stabilité et de qualité des images rencontrés par les GAN traditionnels. Il est moins sensible aux variations dans les données d’entrée. Il est susceptible de produit des images plus réalistes et de meilleure qualité que d’autres algorithmes fondés sur les GAN.

Dans l’ensemble, l’objectif de la génération d’images à l’aide de l’intelligence artificielle est de permettre à un ordinateur de créer de nouvelles images similaires à un ensemble de données d’exemples d’images ou présentant certaines caractéristiques souhaitées.

Et que fait Google?

Après une première génération DeepDream Generator (basée sur une technique appelée rétropropagation du gradient) qui date déjà de 2015, InfoQ a présenté dès 2022 le nouveau modèle Imagen entraîné sur un ensemble de données ImageNet de Google. C’est une autre IA de génération d’images basée sans doute sur la diffusion. Mais Google n’a pas ouvert son algorithme au grand public afin d’éviter tout problème de biais et pour se donner du temps à évaluer les impacts et les risques de ce type de technologies ultrapuissantes. Les testeurs qui ont pu toutefois évaluer et comparer la solution ont conclu que Imagen est bien le plus décoiffant et puissant de tous les modèles du marché. Pour le moment, il faut se satisfaire que de la démonstration sur le site.

Voici un exemple d’utilisation de différentes algorithmes datant de 2019.

Transfert de style d’un dessin avec les images de gingembre. Croisement des séries de mes dessins de nus avec des plaques de métal rouillé, génération de formes libres à partir des séries d’images dont les gingembres pour le dernier cas avec GAN.

Le cas étonnant de Midjourney.

.EMidJourney qui est un text-to-image dont le but n’est pas de viser le réalisme comme DAL-E mais une « beauté artistique ». Et après avoir expérimenter toutes les solutions accessibles, je conviens que les réalisations à partir de Midjourney sont souvent les plus intéressantes pour mon travail personnel.

Sur son site, MidJourney se présente comme un laboratoire indépendant. Selon les informations disponibles, le modèle a été également entraîné sur une grande quantité d’image, mais ne vise nullement la précision. Il intègre en boucle un feed-back basé sur l’activité et les réactions.

Il améliore ainsi les images selon l’utilisation. L’entreprise n’a pas encore révélé quelles technologies elle utilise et les images sont générées sur un cloud utilisant l’énergie verte.

Selon les créateurs du logiciel, jamais aucun service accessible au grand public n’avait permis à un individu d’utiliser autant de puissance de calcul, mais pour cela, il faut le croire, nous n’avons pas de quoi confirmer ou infirmer cette donnée.

Selon les dernières informations, environ un tiers des utilisateurs disent de l’utiliser à des fins professionnelles, par exemple pour tester les variantes d’idée chez un client.

L’outil est accessible via la messagerie Discord en test, puis on peut prendre un abonnement pour exploiter le robot plus fréquemment. Toutes les images générées sont toutefois visibles publiquement.

Et comme pour de nombreuses solutions, il y a des limites et des règles de génération de contenu et certains contenus ne sont pas autorisés. Les textes peuvent être bloqués automatiquement ou par des modérateurs.

Le créateur de Midjourney est David Holtz, PhD de Mathématique, dirigeant pendant 12 l’entreprise Leap Motion.

Exemple d’un image que j’ai générée avec Midjourney

Le Cas DALL-E

Que trouve-t-on sur le site comme explication : DALL-E (ou DALL· E, prononcé Dali, en référence à Salvador Dali) est un mot-valise du robot Pixar WALL-E et du peintre Salvador Dalí.

DALL-E est un modèle de deep learning, lancé par la société OpenAI. La première version a été présentée en 2021, et il y a quelques mois, DALL-E 2 s’ouvre dans une adaptation améliorée et encore plus « effrayante ».

Le modèle Dall-E est une variante multimodale de GPT-3 (Generative Pre-trained Transformer 3, un modèle de langage NLP développé par la société OPENAI) qui a été formé avec 12 milliards de paramètres et qui « échange du texte contre des pixels » et sur des paires texte-image à partir d’Internet. GPT-3 utilise l’architecture de transformateur. GPT-3 a été entraîné sur un grand corpus de données de texte et est capable de comprendre et de générer du texte de manière autonome.

Prenons chaque mot important de cette description pour mieux comprendre.

Il existe des applications du GPT-3 qui ne sont pas du tout dédiées à la génération d’images. Par exemple, on peut analyser les textes sur les réseaux sociaux et en déduire l’angoisse qui règne sur Twitter liée au Covid-19. Mais pour que la machine puisse « disséquer » et « créer une image », de passer par un processus d’apprentissage (machine learning).

L’ensemble des données utilisées pour l’initiation du modèle comprenait 250 millions de paires image/texte (nous comprenons qu’il est impossible de former un tel algorithme à la maison.

Cela semble beaucoup, mais GPT-3 de 2020, au moment de son ouverture aux utilisateurs, était le plus grand modèle de langage jamais formé avec 175 milliards de paramètres (GPT-2 de 2019 n’avait « que » 1,5 milliard de paramètres).

Et pour ajouter : GPT-3 est limité, car il n’est pas capable de raisonner, par exemple par analogie comme BERT de Google ou XLM-R de Facebook. Il est comparable au projet Français Bloom ou au Wu Dao chinois (10 fois plus grand).

Ainsi, on peut dire que DALL-E cumule deux solutions en un. DALL-E utilise l’architecture de transformateur pour traiter la description de texte saisie par l’utilisateur pour extraire des informations qui peuvent être utilisées par un autre modèle entraîné avec les données couples image /text pour générer une image correspondante.

Comment le modèle choisit-il la meilleure solution d’image ?

Pour choisir la meilleure solution d’image pour une description de texte donnée, DALL-E utilise un modèle de prédiction qui a été entraîné sur ces données d’entraînement. Le modèle utilise la compréhension de l’instruction textuelle pour ‘prédire’ l’image la plus probable qui correspond à cette description.

Voilà ce qu’on trouve comme explication sur ‘la recette de cuisine’ :

Les images générées par DALL-E sont organisées par CLIP (Contrastive Language-Image Pre-training), un autre modèle à part entière dont le rôle est de « comprendre et prioriser » sa production pour vous présenter des images de la plus haute qualité et le plus rapidement possible.

CLIP est un système de reconnaissance d’images qui a été « formé » pour comprendre et classer ces images à partir de plus de 400 millions de paires d’images et de texte extraits d’Internet. CLIP associe des images à des légendes entières.

CLIP a été « pré-formé » pour prédire quelle légende (à partir d’une « sélection aléatoire » de 32 768 légendes possibles) était la plus appropriée pour une image, puis lui permettant d’identifier des objets dans des images en dehors de son ensemble d’entraînement.

On peut dire que la force de DALL-E s est liée à la puissance de l’architecture du transformateur GPT-3, donc sa capacité à comprendre les phrases avec une grande précision, un autre modèle comme CLIP conçu pour améliorer les outils de génération d’image grâce au pré-entraînement.

Et si on voulait faire confiance au ChatGPT d’Open Ai pour demander comment marche DALL-E? C’est un peu plus technique comme explication.

Le modèle DALL-E utilise une architecture de réseau neuronal connue sous le nom de transformateur pour générer des images basées sur une description textuelle donnée. Lors de la génération d’une image, le modèle convertit d’abord la description textuelle en une représentation numérique, appelée intégration, qui peut être utilisée ensuite comme une entrée dans le transformateur. Le transformateur traite ensuite « l’intégration » à travers une série de couches, chacune composée d’un mécanisme d’attention (attention mechanism) et d’un réseau de propagation (feedforward network).

Le mécanisme d’attention permet au modèle de se concentrer sur différentes parties de l’incorporation de l’entrée à différents moments. Cela peut être utile lorsque le modèle doit traiter de longues séquences de données, comme des phrases ou des paragraphes de texte, car cela lui permet de se concentrer sur les parties de l’entrée qui sont les plus pertinentes pour la tâche à accomplir.

Tandis que le réseau de propagation qui est un type de réseau neuronal qui applique des transformations mathématiques aux données (donc à l’intégration) avant de les transmettre à la couche suivante (sans retour en arrière ni boucle).

Au fur et à mesure que l’intégration est traitée à travers les couches du transformateur, le modèle utilise les mécanismes d’attention et les réseaux de propagation pour extraire les informations pertinentes et générer une image de sortie.

Pour choisir la meilleure solution pour la génération finale de l’image, le modèle utilise une combinaison de l’intégration d’entrée, de la sortie du transformateur et de toute contrainte ou condition supplémentaire spécifiée par l’utilisateur. Le modèle combine ensuite ces éléments de manière optimisée pour l’image de sortie souhaitée.

Dans l’ensemble, le modèle DALL-E utilise une combinaison de traitement de texte, de mécanismes d’attention et de réseaux de propagation pour générer une image de sortie pertinente pour la description du texte d’entrée. Il choisit la meilleure solution pour la génération finale de l’image en tenant compte du texte d’entrée, de la sortie du transformateur et de tout contrainte ou condition supplémentaire spécifié par l’utilisateur.

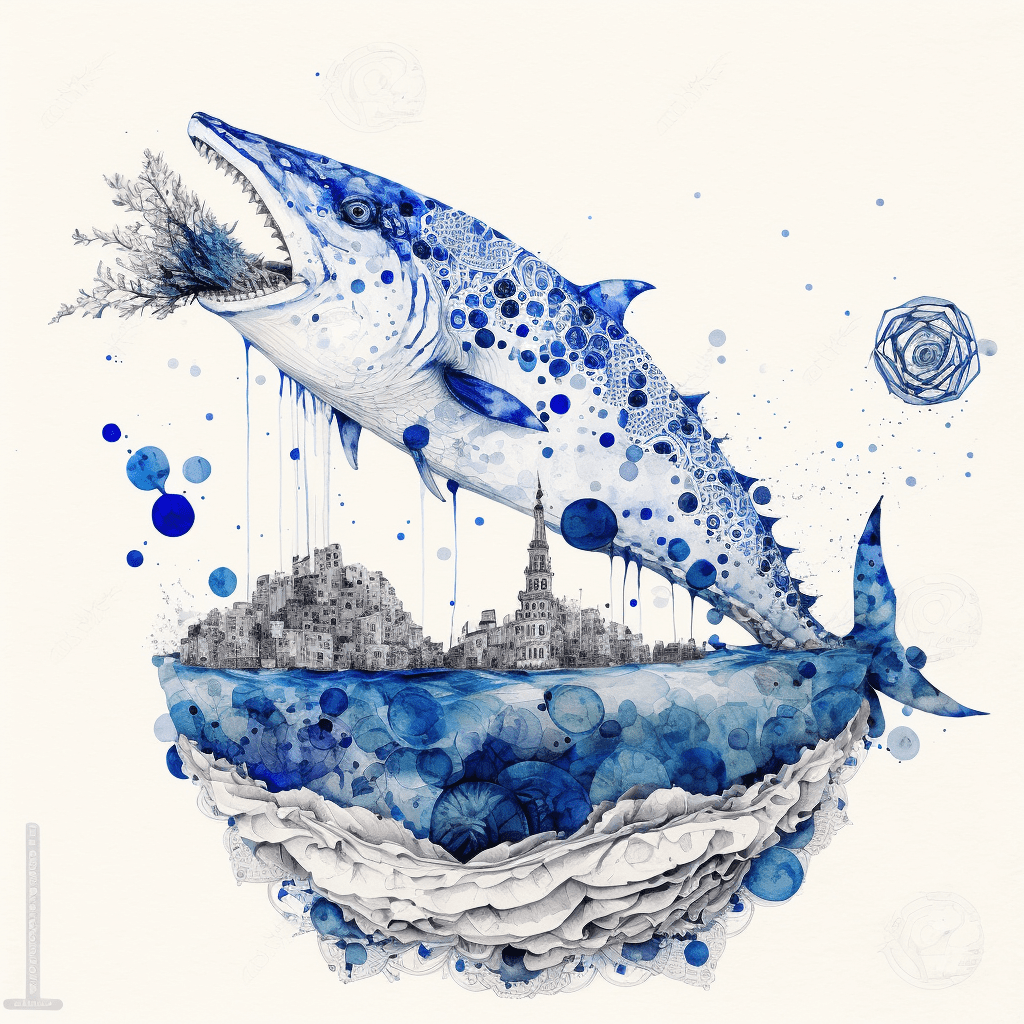

uU exemple d’image générée, puis retravaillée en dessin en mode pastel.

Regardons désormais le modèle ‘concurrent’ Stable Diffusion.

Stable Diffusion est un modèle proposé par CompVis, Stability.ai et LAION. Il s’agit du premier projet de génération d’images entièrement open source. LDM a été développé par le groupe de recherche sur la vision industrielle et l’apprentissage de l’Université Ludwig Maximilian de Munich et décrit dans un article présenté lors de la récente conférence IEEE / CVF Computer Vision and Pattern Recognition (CVPR).

Il est basée sur une technique de génération d’images appelée modèles de diffusion latente (LDM).

Les LDM génèrent des images en « débruitant » itérativement des données dans un espace de représentation latent, puis en décodant la représentation en une image complète.

OUF, c’est un peu ardu comme explication.

Je vais essayer d’expliquer dans un langage plus accessible, donc moins précis et désolée pour les imprécisions.

Pour générer une image, l’utilisateur fournit une image initiale et un ensemble de paramètres d’entrée qui spécifient les propriétés souhaitées de l’image générée. L’algorithme utilise ensuite ces paramètres d’entrée pour modifier l’image initiale en une série d’étapes.

L’idée derrière cette approche est de modifier itérativement une image initiale d’une manière guidée par ces paramètres d’entrée, dans le but de produire une image visuellement similaire à l’image d’entrée.

Par exemple, les paramètres d’entrée peuvent spécifier la couleur ou la texture de l’image générée, le niveau de détail ou le style général. L’algorithme utilise ces paramètres pour ajuster l’image initiale d’une manière cohérente avec les propriétés spécifiées.

Ce processus est répété jusqu’à ce que l’image générée réponde aux critères souhaités, après quoi l’algorithme s’arrête et l’image finale nous est proposée. L’image générée est de facto une version modifiée de l’image initiale qui a été guidée par les paramètres d’entrée.

Les modèles de diffusion comme Stable Diffusion s’inspirent de la thermodynamique hors équilibre.

Et cela veut dire quoi ? Oh la la, je crois que nous allons nous arrêter là.

Mais, une question surgit sans doute à la lecture de l’explication précédente. Comment nous pouvons fournir à Stable Diffusion un prompt, alors qu’on nous parle d’une ‘image initiale’ ?

Contrairement à DALL-E, qui utilise un modèle de traitement du langage naturel (l’architecture de transformateur) pour comprendre les descriptions de texte saisies par l’utilisateur, Stable Diffusion utilise des données d’entrée sous forme de vecteurs numériques qui représentent les caractéristiques de l’image souhaitée.

Les utilisateurs peuvent spécifier ces caractéristiques en utilisant des paramètres numériques ou en fournissant des exemples d’images cibles. Depuis un certain temps, le modèle peut recevoir une description textuelle d’une image souhaitée et générer une variante qui correspond à cette description. Il peut également générer une image réaliste à partir d’un simple croquis plus une description textuelle de l’image souhaitée.

La façon dont Stable Diffusion transforme des descriptifs textuels en une représentation numérique pour le modèle LDM n’est pas spécifié. C’est le secret du chef.

Je pense que nous pouvons nous satisfaire des explications pour notre besoin actuel.

Même le Chat GPT se défile et me suggère d’aller parler au concepteur pour en savoir plus ! Voilà sa réponse.

Dans le cas de Stable Diffusion, il est possible qu’une architecture de transformateur ait été utilisée pour traiter les descriptions de texte naturel et les transformer en une représentation numérique qui puisse être utilisée par le modèle LDM pour générer des images. Cependant, sans plus de détails sur l’implémentation précise de Stable Diffusion, il est difficile de dire exactement comment le modèle a été conçu et comment il fonctionne.

Il est également possible que Stable Diffusion ait utilisé une autre architecture de réseau neuronal ou un autre mécanisme pour traiter les descriptions de texte naturel et les transformer en une représentation utilisable par le modèle LDM. Si vous avez des questions spécifiques sur la façon dont Stable Diffusion traite les descriptions de texte naturel, il serait peut-être utile de contacter les développeurs du modèle pour obtenir des informations plus détaillées.

Dans les articles suivant je vais expliquer comment j’aborde l’utilisation des générateur d’image depuis le début et mes méthodes de travail.

Vous pouvez aussi parcourir tous les articles précédents sur le sujet sur le blog

IA-esquisses, comment augmenter votre inspiration.

Reprendre et retravailler ses vieux dessins et peinture avec Midjourney avec la commande /BLEND pour plus d’inspirations.

L’inspiration artistique augmentée par l’IA, mythe ou réalité.

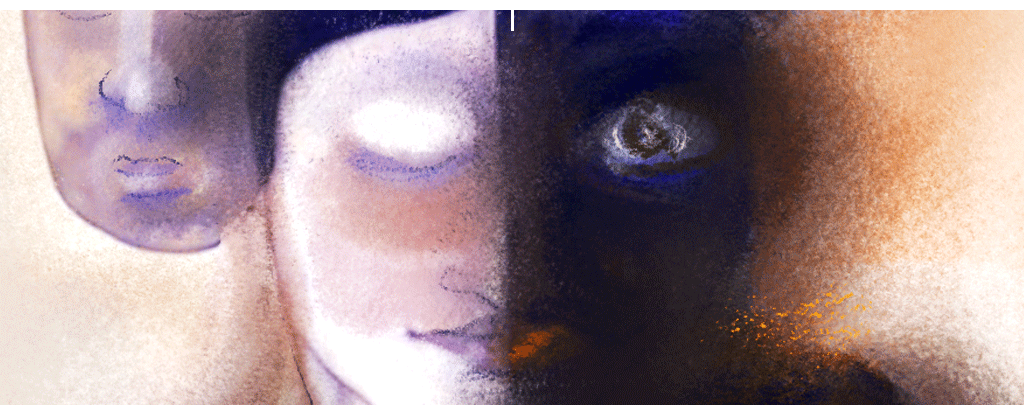

Dans mon exposition à Prague en 2022, je joue avec une certaine ironie avec l’idée d’anthropomorphisme en créant l’univers « Patternworld », peuplé de créatures hybrides « peuples GAN fabriqués à partir de puces ». En réalité, le sujet de la limite entre l’humain et inhumain est très riche et m’offre de nombreux possibilités pour m’inspirer.

La frontière entre humain et inhumain est en train de bouger.

Je joue beaucoup dans mes peintures avec la limite entre l’humain et l’inhumain, la vision anthropomorphique de l’IA et sur l’hybridation homme-machine.

Ce sujet me laisse perplexe. J’ai le sentiment que la frontière entre humain et inhumain a déjà évolué. Le phénomène est encore difficile à saisir et à percevoir, mais il est là.